Les logiciels de CAO, DAO, FAO, …

retour sur les 60 ans d’évolution de ces outils

qui ont changé le monde de l’industrie.

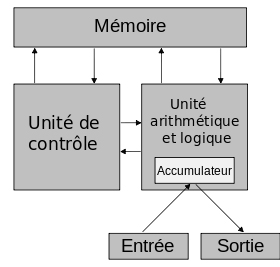

Le concept remonte à la fin des années 50 : avec les progrès de l’informatique, des ingénieurs jettent les bases de ce qui deviendra plus tard le premier logiciel de CAO. Au tout début les logiciels tournent sur des machines énormes, pesant plusieurs tonnes, pour se réduire en fin de compte à des mini stations portables au XXIe siècle. Retour sur ce qui fut le départ d’une révolution dans le secteur de la conception industrielle.

Patrick Hanratty et Ivan Sutherland sont crédités comme étant les pionniers de la CAO moderne, ce sont leurs travaux pratiques et théoriques qui vont permettre au fil du temps l’émergence d’outils destinés à simplifier et améliorer la fabrication et la conception de pièces industrielles. Et tout cela à l’aide des technologies informatiques encore balbutiantes du début des années 60.

Patrick Hanratty

Développeur de ADAM, premier logiciel CAO compatible multi-systèmes.

Ce système fait aujourd’hui figure du premier vrai standard en CAO

Ivan Sutherland

Concepteur et théoricien du système SKETCHPAD,

il est à l’origine des systèmes d’interface graphiques dédiés à la CAO.

Années 1950

En 1957, Patrick J. Hanratty développe le programme PRONTO pour General Electric. C’est de cette façon que voit le jour le premier langage de programmation de contrôle numérique de l’histoire.

Années 1960

Au début des années 60, Ivan Sutherland, au travers de sa thèse de doctorat, propose un concept novateur de système informatique capable d’afficher des plans sur écran qu’il serait possible de manipuler à l’aide d’un stylo optique. La seule limite reste l’informatique de l’époque, encore embryonnaire mais les concepts d’interface graphique et de modélisation 3D débutent à ce moment-là.

Durant la décennie des années 60 jusqu’au milieu des années 70, la CAO est réservée uniquement aux très grosses entreprises (IBM, Lookeed Martin, Honeywell, NASA, Dassault,...) qui développent en interne des solutions propriétaires.

Années 1970

En 1971, Patrick J. Hanratty se lance dans l’écriture du code d’un nouveau logiciel de CAO nommé ADAM, ce système de conception graphique, de dessin et de fabrication interactif a été écrit en Fortran et conçu pour fonctionner sur pratiquement toutes les machines. Ce succès retentissant a ensuite été mis à jour pour fonctionner sur des ordinateurs 16 et 32 bits. Aujourd'hui, 80% des programmes de CAO trouvent leurs origines dans le programme ADAM.

En 1972, Ed Catmull et Fred Parke réalisent la Première animation 3D, d'une main et d'un visage, à l'aide d'un logiciel qu'ils ont développé.

Catmull, va ensuite travailler chez ILM et deviendra plus tard un des fondateur de Pixar.

1975 Martin Newell veut tester des algorithmes de rendus 3D, dans le cadre de son doctorat. A l'époque il n'existe pas beaucoup d'objets 3D complexes, et l'accès à ces objets semble très compliqué.

Newell décide donc de concevoir son propre objet 3D afin de pouvoir réaliser ses tests. Pour ce faire, il digitalise manuellement une théière, en utilisant les courbes de Bézier.

Du fait de sa complexité, ce modèle va devenir célèbre, on le retrouve aujourd'hui dans de nombreux logiciels, en tant qu'objet standard.

En 1977, Digital Equipment Corporation (DEC) lance le VAX 11/780 exécutant le système d'exploitation VMS à mémoire virtuelle 32 bits. Ces machines seraient utilisées pour le traitement par lots, le partage du temps et l'informatique en temps réel. Ils sont vendus avec un réseau informatique intégré et des méthodes normalisées pour dialoguer entre les langages de programmation. Cette machine est un concurrent sérieux pour l'IBM 360 qui domine le marché de la CAO.

La même Année Dassault System system lance CATI, Lookeed Martin lance CADAM.

Suite au rachat de United Computing par l’avionneur Mac Donnell Douglas en 1976, le logiciel ADAM va subir une refonte complète pour devenir Unigraphics R 1.0 (NX) de Siemens qui est lancé en Avril 1978. Les systèmes de CAO se développent et sont utilisés par l'aérospatiale, le secteur automobile et les industries. Les systèmes permettant de faire fonctionner un logiciel de CAO, sont en train de passer sur des « mini-ordinateurs », il faut comprendre qu'une machine de ce genre, pèse environ 500Kg, et qu’il faut envoyer plusieurs techniciens pour la déployer chez le client. Le chargement des logiciels se fait ensuite via des bandes magnétiques. Nous sommes encore à des années lumières de ce que nous connaissons aujourd’hui.

Années 1980

L’IBM PC lancé en 1981, va changer la donne en propulsant la CAO à grande échelle. Son atout le plus important est son prix, ce qui va permettre une démocratisation rapide de la CAO dans de nombreuses sociétés de moyenne et petite taille. C’est à cette époque que les premières versions des logiciels actuels vont voir le jour. L’avènement de la micro-informatique grand public des années 80, va donc considérablement réduire la taille des énormes systèmes jusque-là utilisés pour faire fonctionner les complexes logiciels de CAO. Unigraphics en version 2.1 est porté sur la gamme DEC VAX.

1982, voit la création de SUN Microsystems. SUN a contribué à populariser UNIX pour l'informatique scientifique. Chaque poste de travail, qui pouvait prendre place sur le bureau d’un ingénieur, contenait un processeur, un périphérique graphique ou un terminal et des périphériques d’entrée. Ils étaient faciles à mettre en réseau pour faciliter le partage et l’accès aux données et au traitement. Les postes de travail UNIX individuels seraient aux finals beaucoup plus puissants qu'un mini-ordinateur 11/780 ou un IBM 360.

Toujours en 1982, un groupe de programmeurs créent la société Autodesk, et son fameux logiciel AutoCAD. La première version d’AutoCAD est annoncée en novembre lors du salon Comdex de Las Vegas et fera l’objet de démonstrations sur un Z80, un Victor 9000 et un IBM. Elle sera livrée aux premiers clients dès décembre de la même année.

1982, c'est aussi le début de l'utilisation de la CAO au cinéma, avec le film TRON de Walt Disney. Le Logiciel qui permet de réaliser une partie des scènes véritablement synthétiques est SynthaVision de chez MAGI.

Ce n'est pas encore un logiciel de CAO vraiment destiné à l'industrie cinématographique, mais ses capacités de modélisation à base de polygones se prêtent bien aux besoins de l'industrie graphique naissante.

A l'époque, un ordinateur central CRAY disposait de 8 Mo de mémoire pour un coût de 7 millions de dollars. Pour TRON, chaque rendu nécessitait 18 Mo de mémoire.

Ainsi, même sur un CRAY, les animateurs n'auraient pas pu visualiser une seule image, quel que soit l'ordinateur utilisé, il ne pouvait restituer qu'une seule ligne de balayage à la fois.

Pour voir le résultat final de l'image, il fallait attendre que les lignes soient combinées ensembles, véritable travail de titan pour l'époque.

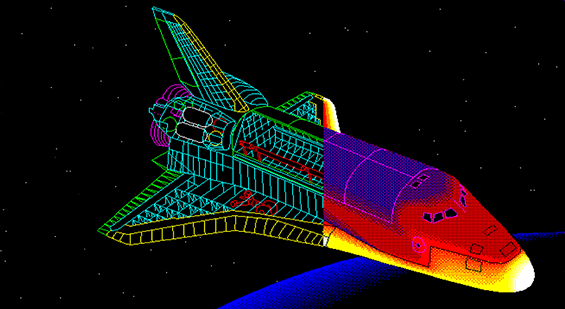

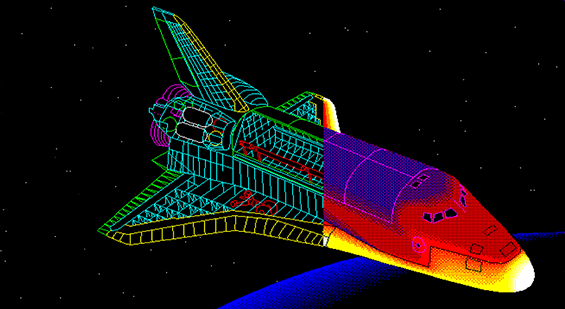

L'engouement pour l'image de synthèse au cinéma atteint son sommet en 1984, avec un petit film de SF devenu culte depuis : The Last Starfighter.

Comme TRON, ce film est un des pionniers du genre à inclure de la vraie image de synthèse

(300 scènes, soit plus de 27 minutes de pure CGI, avec un format d'image de 5000 x 3000 pixels) pour des séquences réalistes de combat spatiaux.

Pour venir à bout de ce travail titanesque, il aura fallut : 1 CRAY XMP, 2 DEC VAX 11/780 et 120 Stations de travail IMI 500.

Malgré la prouesse technique, le monde du cinéma de l'époque a encore du mal à croire que la CGI deviendra le fer de lance des effets visuels.

A partir de 1985, des gammes de machines compactes, très puissantes et de moins en moins chères vont faire leur apparition.

L’AMIGA 1000 est le premier vrai système multimédia de l’histoire, sa carte mère inclue un jeu de processeurs dédiés pour le son l’image, l’animation, afin de décharger le processeur principal.

L’atout majeur de cette gamme de nouvelles machines est le prix, qui reste abordable au grand public.

C'est sur cette machine que seront développé les logiciels de 3D : Cinéma 4D et Lightwave 3D. Logiciels à la base des effets visuels de nombreuses séries TV des années 90 / 2000

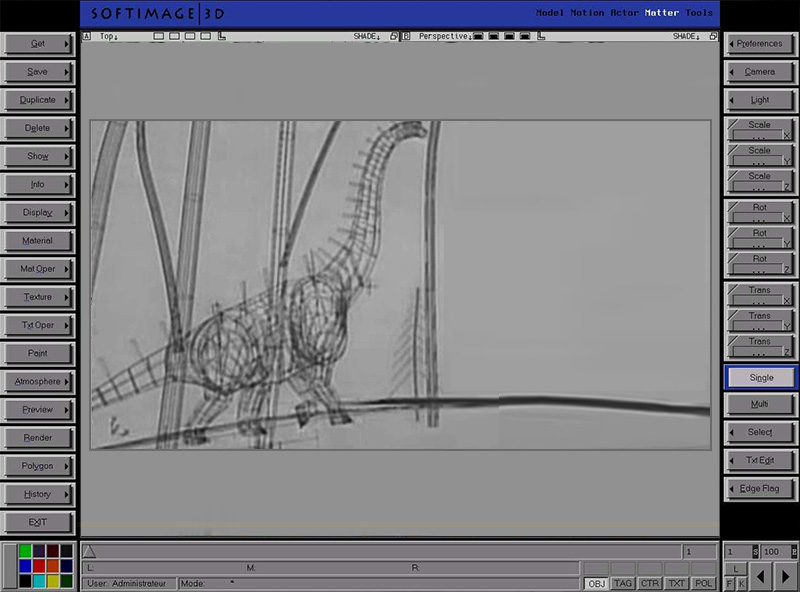

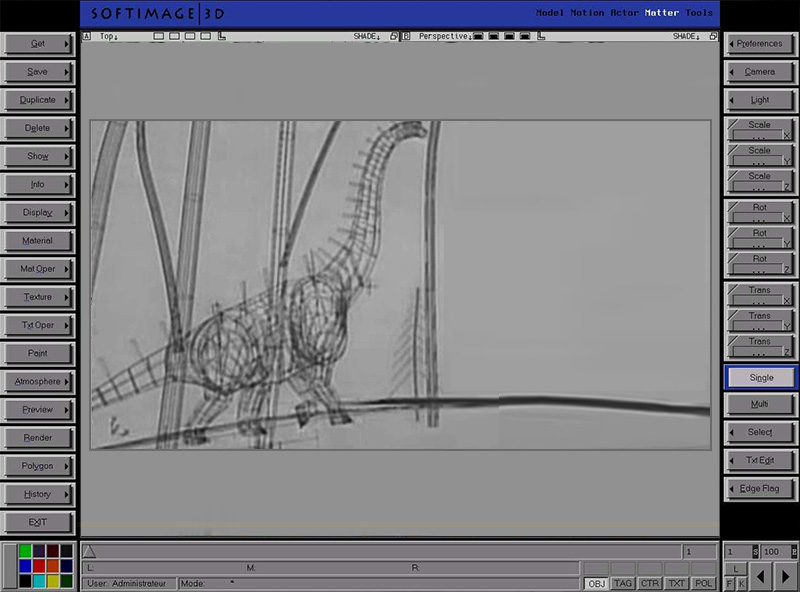

La CAO à destination de l’industrie cinématographique et du divertissement se développe en 1986, avec l'apparition de Softimage 3D par Daniel Langlois à Montréal.

Softimage 3D est le pionnier des logiciels commerciaux de CAO dont la cible est l'industrie du cinéma.

C’est ce fameux logiciel de 3D qui servira (entre autres) aux effets spéciaux des films Abyss et Jurassic Park. Le logiciel qui tourne alors sous UNIX, nécessite une machine très onéreuse pour pouvoir fonctionner (Silicon Graphics de Sun). Pour l'époque son interface utilisateur est novatrice.

Dans le domaine de la CAO industrielle, les améliorations sont beaucoup moins notables, surtout en ce qui concerne l'ergonomie des interfaces utilisateurs. Le paradigme des interfaces des logiciels de CAO à l'usage de l'industrie du divertissement vont grandement inspirer les futurs développements de ceux de la CAO industrielle.

AutoCad 2.18 (1986)

En 1988, Unigraphics porte sa solution NX sous UNIX, cela marque le début de la fin des gros mainframes propriétaires(1) .

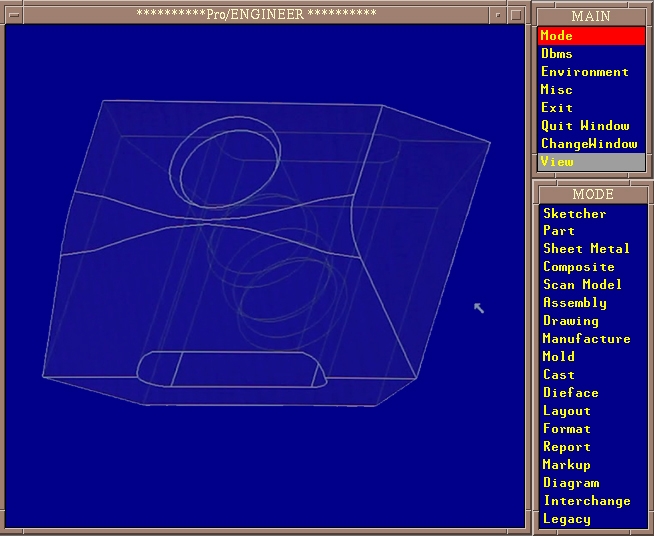

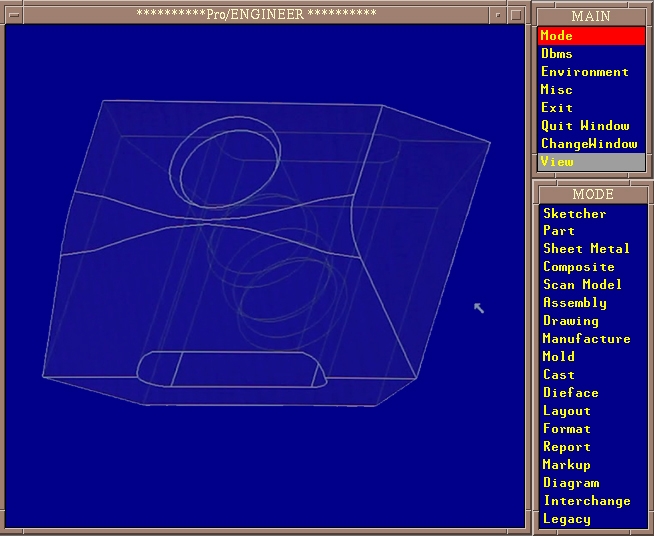

L’année 89, marque un tournant dans la CAO, avec la version 1.0 de Pro / Engineer.

Il introduit la modélisation paramétrique(2) des solides, basé sur les fonctionnalités. Un paradigme que tous les systèmes de CAO courants copient. Pour la première fois, la modélisation solide devient une alternative productive à la modélisation filaire. Les responsables techniques peuvent désormais acheter un poste de CAO sans l’approbation du département MIS (Département Méthodes pour l’ingénierie des systèmes.)

Pro Engineer Release 1.0 les logiciels de CAO entrent dans l’ère de la 3D paramétrique.

De son coté, Lookheed Martin propose son logiciel CADAM à la vente, et IBM le rachète. Il faut préciser qu’à cette époque, Lookeed utilise déjà CATIA pour ses projets avancés, CADAM son logiciel propriétaire n’a plus vraiment d’intérêt stratégique. CATIA se révèle être bien plus avancé en terme de conception puisqu’il intègre depuis longtemps une véritable vue en 3D, ce qui n’est toujours pas le cas de CADAM. La fin de la décennie 80 voit aussi une évolution majeure dans l’utilisation des systèmes CAO par l’abandon progressif des mainframes propriétaires qui, jusque-là permettaient de faire fonctionner les logiciels.

Années 1990

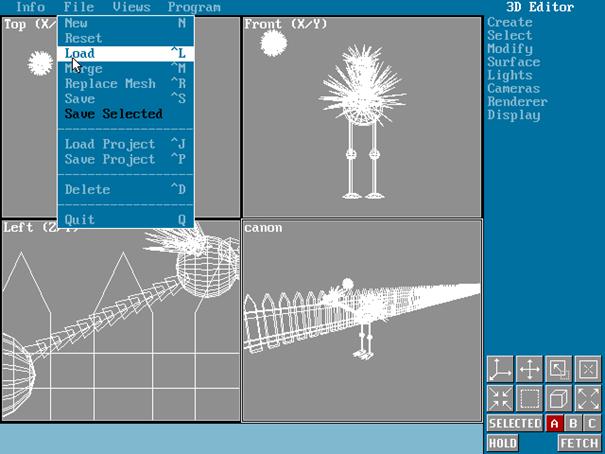

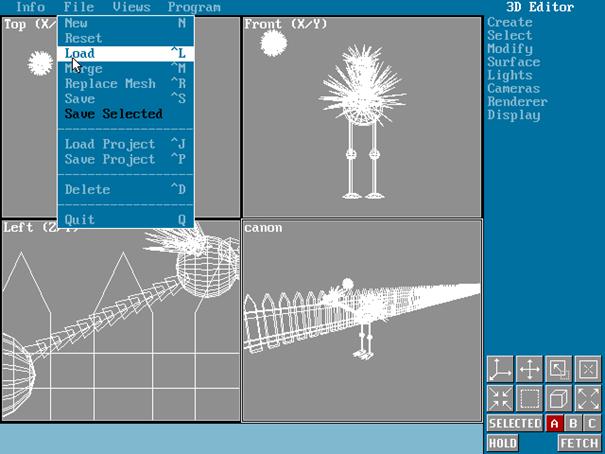

En 1990, dans le domaine de la CAO ludique Autodesk lance le logiciel 3D studio sous MSDOS. D'abord situé sur le même segment de marché que Lightwave et cinema 4D, le logiciel va connaitre une certaine notoriété auprès des professionnels, et du grand public.

1991, 3D studio sous MSDOS de chez Autodesk. L’infographie 3D ludique, se démocratise en se déployant sur un simple PC.

En 1993, Spielberg, réalise le film Jurassic Park, après avoir regardé des séquences en stop motion classique et les mêmes séquences en CGI, il opte pour une version tout numérique pour animer les monstres préhistoriques. C'est Softimage 3D et sa collection d'outils, qui va permettre cette prouesse technologique. Cette fois le monde de l'industrie cinématographique, est convaincue que la technologie de CAO est mature pour les effets visuels au cinéma.

Softimage 3D en 1993

L’arrivée des processeurs Pentium de chez INTEL en 1992 sonne le glas des mini-ordinateurs et des stations de travail très onéreuses fonctionnant sous UNIX et autre. L'ensemble des logiciels de CAO qui fonctionnaient sous de gros systèmes et des stations de travail coûteuses, va commencer à migrer massivement sur PC. Tous les secteurs de l'industrie sont maintenant concernés.

Microsoft rachète Softimage en 1994, et décide de le porter sous windows NT, mais ne le rends pas plus accessible à un large public d'utilisateurs.

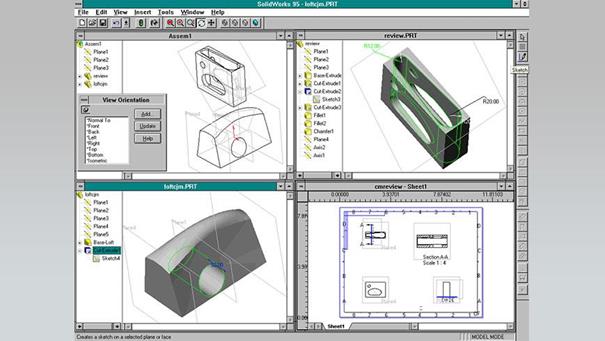

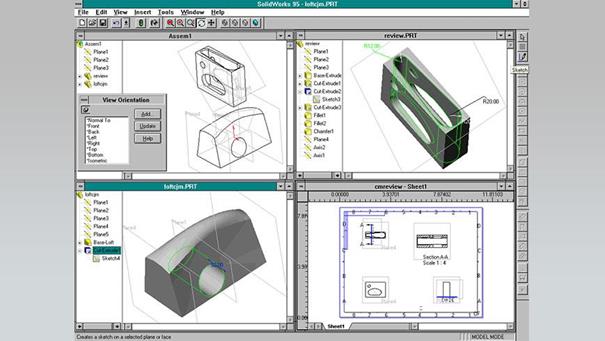

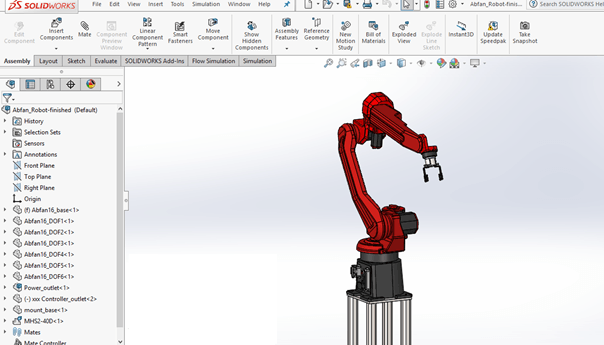

Solidworks95, en plus de la modélisation ce nouveau logiciel va intégrer de puissants outils de modélisation.

La société Solidworks sort ainsi son logiciel en 1994. Celui-ci permet outre le dessin technique de concevoir des ensembles et sous-ensembles 3D très complexes, proche d’un process de fabrication. Des fonctions supplémentaires comme la simulation de test de résistances des matériaux, en font un outil incontournable du secteur. Ce concurrent de CATIA est racheté par Dassault Systèmes en 1997.

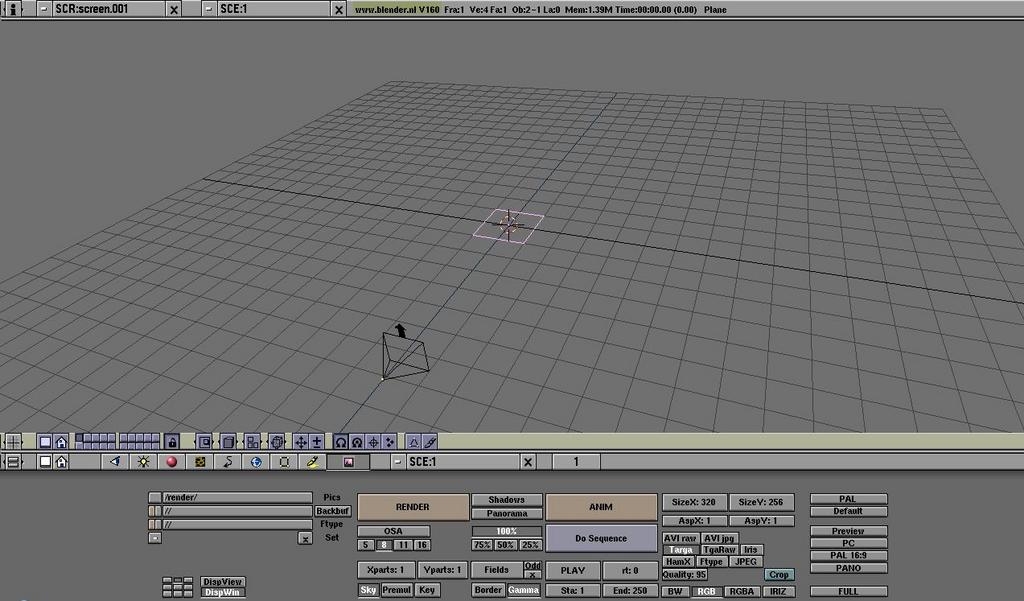

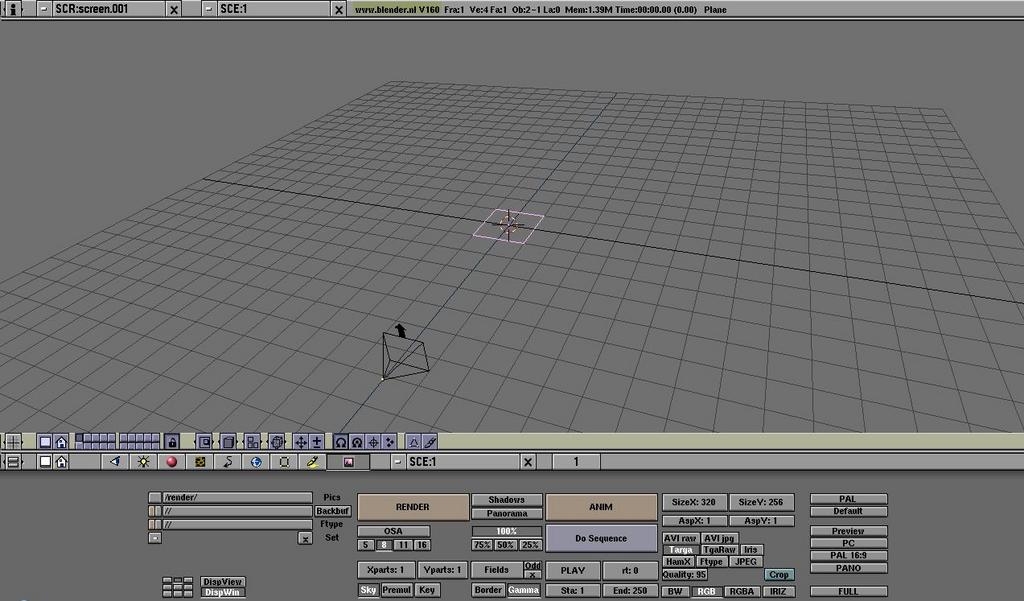

En 1995, un logiciel de 3D à but ludique fait son apparition : Blender. A l'origine développé sur AMIGA sous le nom de "Trace", son auteur Ton Roosendaal, décide de créer un logiciel Open Source. Il obtient des fond et ouvre la société NaN en 1998 pour développer et partager Blender.

La CAO entre dans le monde de l'Open source avec Blender, un petit logiciel qui va devenir la référence en la matière.

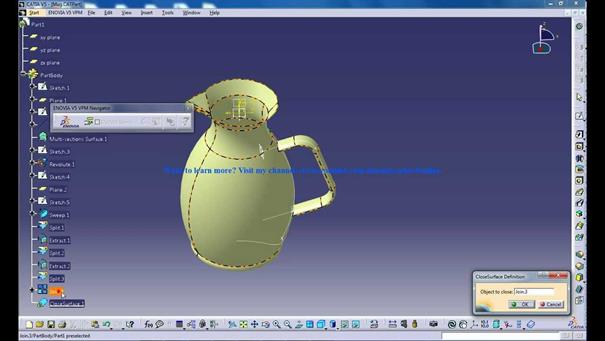

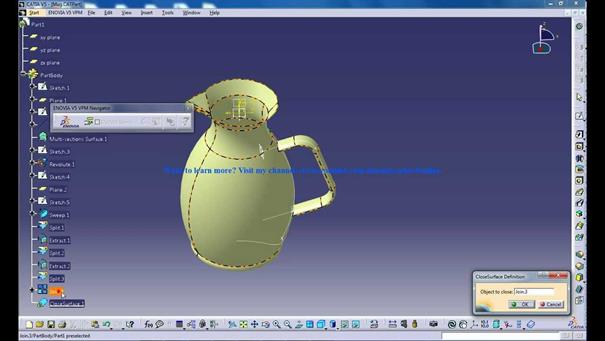

En 1998, CATIA de chez Dassault Systèmes abandonne à son tour le monde mainframe, et s’installe sous UNIX et Windows NT.

CATIA V5.0

En 1996, PIXAR sort le premier film entièrement en images de synthèse : Toy Story, résultat des dix ans de développement de son logiciel RENDERMAN. L'industrie du divertissement, envisage maintenant la CAO comme un outil de production fiable dont les résultats permettent de réaliser d'impressionnant effets spéciaux.

Toujours en 1996, Autodesk, lance 3D Studio Max R1.0 sous windows. L'interface logicielle très ergonomique, permet la modélisation et l'animation dans un seul produit.

L'aspect ludique, fait que le produit se place alors parmi les premiers de cette période. La communauté utilisateurs devient très importante, et développe ensuite des plugins pour améliorer les capacités.

Par ailleurs le logiciel propose un système d’animation de personnage pré-paramètré dans son éditeur : Character Studio. C’est une petite révolution dans le domaine de la production cinématographique, mais aussi dans le monde du jeu vidéo. C'est la facilité d'accès à 3D Studio (Dos et Windows), et son côté ludique adapté aux jeux vidéos, qui va permettre à tout un public de passionnés de se former, contrairement à des outils comme Softimage fonctionnant sur des supports totalement inaccessibles.

En 1999 Autodesk lance Inventor, qui devient un concurrent sérieux en termes de fonctionnalités, pour CATIA, Solidworks et Unigraphics.

Années 2000

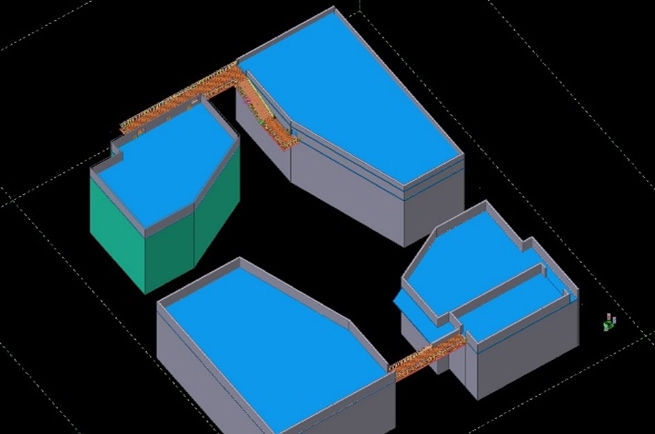

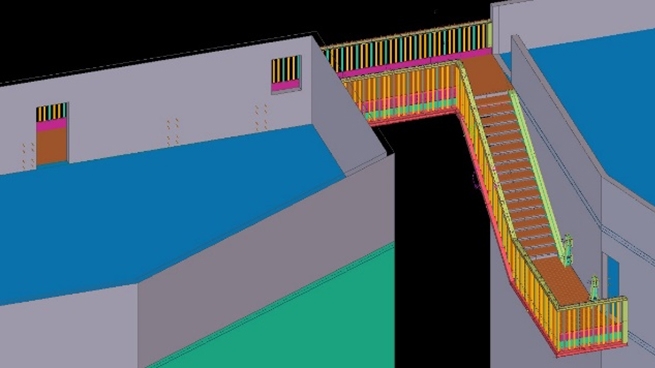

Le portage sur Windows NT des grands logiciels de 3D va participer à la démocratisation de ceux-ci. Une énorme communauté d'utilisateurs et de passionnés va créer des bibliothèques gratuites d'objets 3D sur internet. Les principales améliorations de cette décennie se font au niveau de l’affichage en temps réel d’un nombre très important de pièces dans les ensembles et sous-ensembles. La puissance des stations de travail autonomes au travers des nouvelles cartes graphiques permettra l’affichage d’ensemble très complexe, et le début des simulations en temps réels.

Microsoft arrête Softimage à sa version 4.0 en 2002, au profit de sa version réécrite plus spécifiquement pour NT : Softimage XSI.

CATIA V6 2008 - Dassault system

En 2008, CATIA V6 permet de réaliser une maquette numérique fonctionnelle, au travers d’une simulation. Cette maquette numérique complète du produit prend en compte toutes les vues que nécessite le développement produit : les exigences autant que les définitions fonctionnelles, logiques et physiques.

Dans le domaine de la CAO ludique, c’est une véritable explosion de nouveautés proposant toutes des fonctionnalités différentes et de plus en plus ergonomiques. Le monde de l’open source, va finir d'imposer Blender, qui va devenir le standard de ceux qui souhaitent pouvoir faire de la 3D gratuitement.

En 2008 Autodesk rachète Softimage et commence l'intégration de sa technologie à sa suite de logiciels, occupant le même segment de marché : Maya et 3dsmax

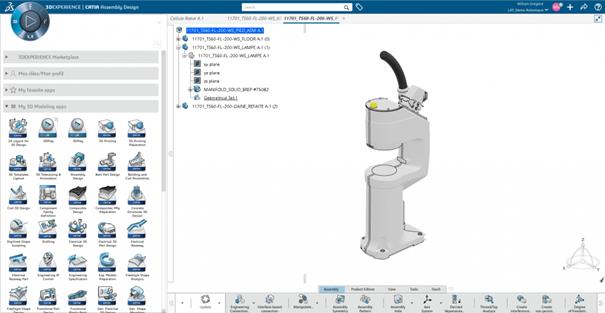

Années 2010

L’arrivée d’internet depuis plus de 10 ans et les améliorations constantes des services en ligne vont voir apparaître des applications de CAO en ligne pouvant exploiter la technologie du Cloud.

Dans la décennie des années 2010, le site GrabCad est créé. Il permet le partage via une communauté d’utilisateurs, d’objet 3D normalisés. Et avec le cloud, il est désormais possible à un ingénieur de travailler avec son PC portable depuis n’importe où. A noter, l'apparition d'applications de 3D temps réel, tels que Unity, openspace 3D, permettant la navigation au sein d'un univers virtuel.

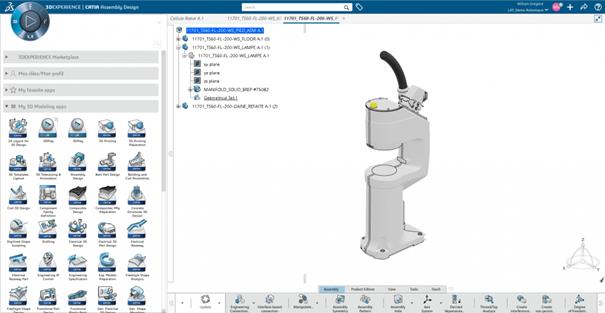

Station de travail autonome (Modèle HP)

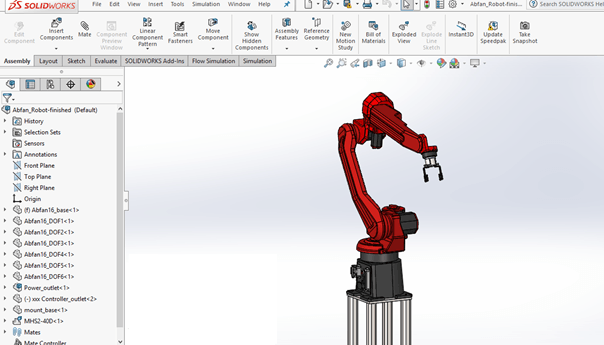

Solidworks

En 2012 Autodesk lance Autodesk 360 et l’utilisation du cloud dans le flux de production de ses suites logicielles.

Des applications dédiées aux smartphones et tablettes voient le jour tel que 3D AP en 2013. Il est maintenant possible de visualiser une pièce 3D complexe depuis un appareil qui tient dans la main.

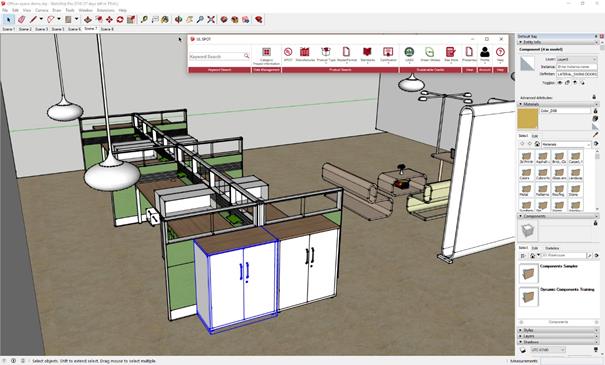

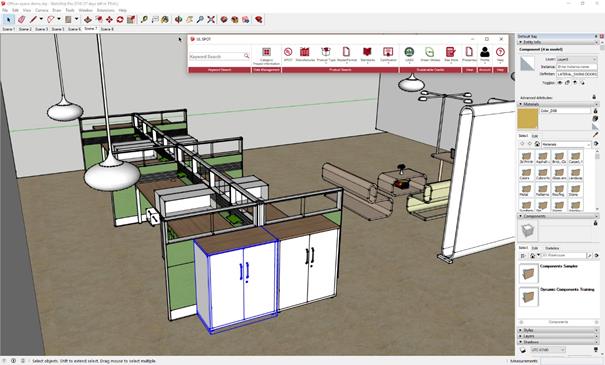

Google sort l'application en ligne Sketchup, qui permet de créer rapidement des objets 3D.

Sketchup de Google

En 2014, Autodesk annonce l'arrêt définitif du développement de Softimage XSI. La décision fait polémique, les professionnels de la CGI expliquent qu'Autodesk aurait racheté Softimage pour récupérer sa technologie.

Mais le logiciel semble surtout avoir été victime de son inaccessibilité au grand public, contrairement à ses concurrents. Autodesk, va cependant maintenir le logiciel Softimage jusqu'en 2016, puis le retirera progressivement du marché au profit de Maya et 3Dsmax qui hériteront d'une grande partie des ses aspects techniques.

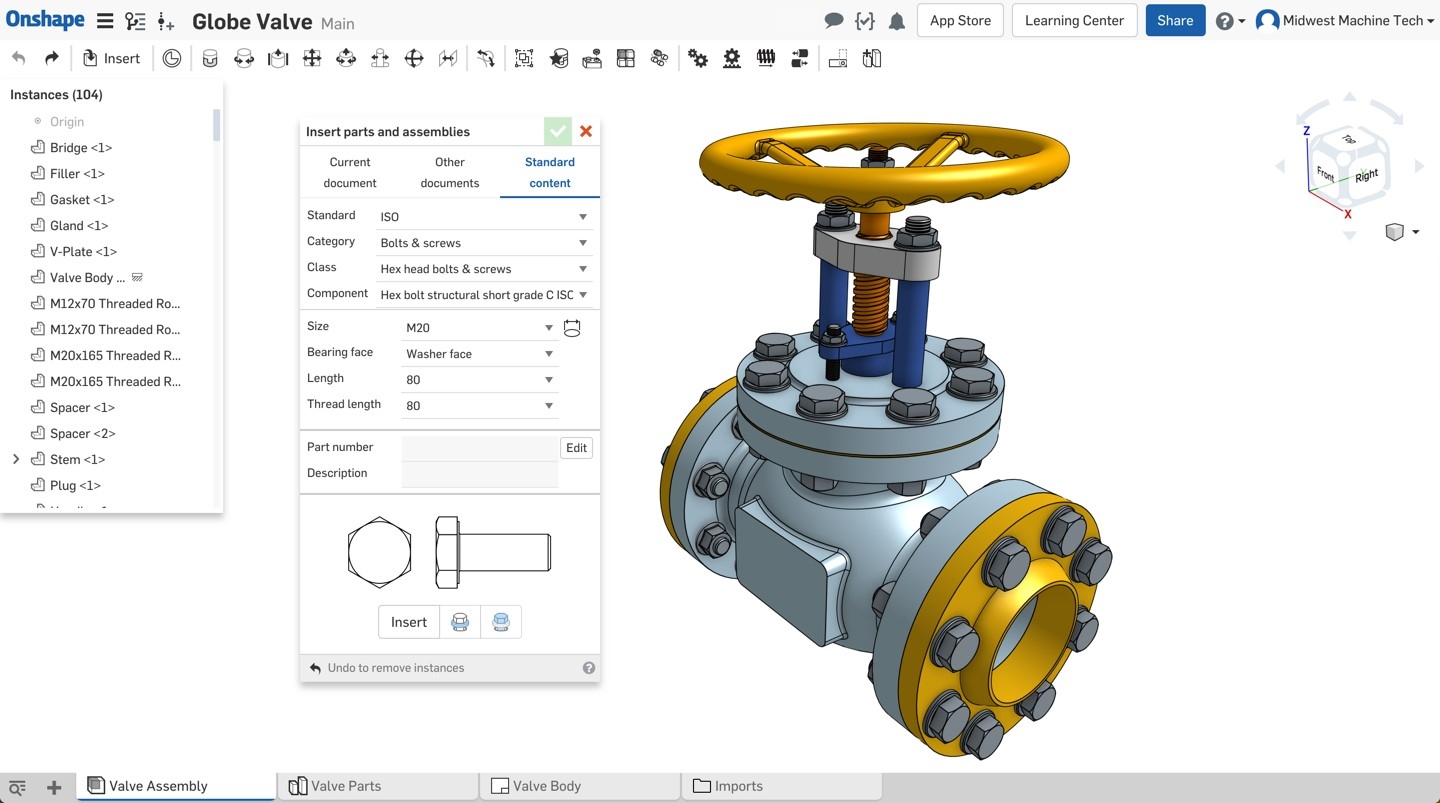

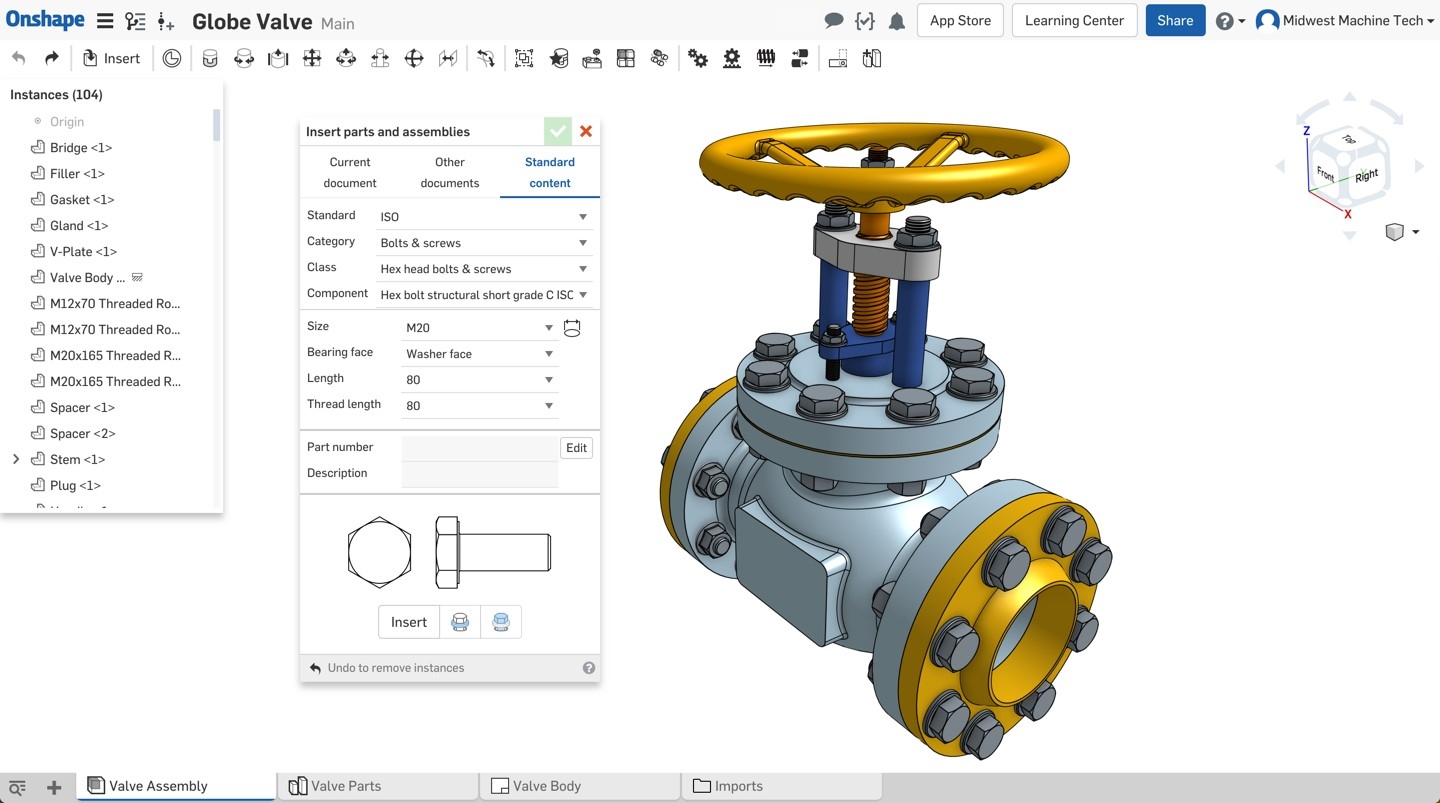

En 2015, ONSHAPE, lance un système de CAO depuis le cloud.

ONSHAPE

La CAO a fait son entrée dans le grand public, il est désormais possible de concevoir en quelques clics des maquettes virtuelles complexes, grâce à des outils simples, ergonomiques et très puissants.

Les applications sont nombreuses, et des innovations ont fait leur apparition comme l'impression en 3D, à partir d'objets virtuels. En effet, il est aujourd'hui possible dans le cadre industriel et personnel, de concevoir des prototypages, et des mini séries d'un produit, en très peu de temps.

Années 2020

L'apparition de l'IA dans le domaine de la CAO, elle va permettre d'automatiser des tâches répétitives, puis progressivement de permettre d'accélérer le conception de produits. Via la conception générative, une méthode où l’algorithme explore des milliers de permutations pour identifier des solutions optimales répondant à des contraintes spécifiques (poids, résistance, coût), la conception du produit final se retrouvera largement optimisée . Des logiciels tels que Fusion 360 et SolidWork utilisent cette approche pour produire des structures spécifiques, optimisée mais toujours robustes, et souvent contre-intuitives pour le technicien humain. Dans le domaine de l'aérospatial, ces outils vont permettre une optimisation significative de la masse des composants critiques sans remettre en cause la résistance mécanique.

Elle ne peut cependant pas remplacer le technicien, car l'expérience de l'IA se fonde uniquement sur des exemples existants de sujets classiques stockés en base de données. Un conception originale ne pourra se faire qu'à l'aide de spécialistes.

Années 20XX…

La complexité des fonctions et des applications liées aux logiciels de CAO / DAO reste dépendante des machines qui les font tourner. On peut imaginer, avec l’avènement de l’informatique quantique, la conception temps réel d'ensembles très complexes. Et grâce à la réalité virtuelle augmentée, permettre au concepteur de simuler son fonctionnement. De même, après avoir conçu l'ensemble dans un système virtuel, il sera possible au technicien, de le réaliser dans le monde réel via une imprimante 3D, en très peu de temps.

(1) Mainframe : Désigne un ordinateur centralisant toutes les données, auquel sont connecté des terminaux. Le mainframe, est capable de faire tourner des dizaines de systèmes d'exploitation simultanément. Le terme désigne particulièrement les machines type IBM 360/370. Progressivement remplacé par des systèmes plus petits dans les structures de tailles moyennes, le mainframe, est encore utilisé aujourd'hui par les très grosses entreprises.

(2) Modélisation paramétrique : Le paradigme de modélisation paramétrique répond à une approche de conception technique et fonctionnelle. Le concepteur doit avoir une idée relativement précise de ce qu'il va faire pour anticiper et définir les contraintes des fonctions et les dépendances. Toute modification de la conception est ainsi répercutée en aval, d'une manière prédéfinie.

Crédits photos : Public domain images, freestock photos, fotolia, National archives, NX Siemens, Solidworks, Sketchup, CATIA.

Pour aller plus loin :

https://fr.wikipedia.org/wiki/Th%C3%A9i%C3%A8re_de_l%27Utah

https://fr.wikipedia.org/wiki/Edwin_Catmull

https://fr.wikipedia.org/wiki/Starfighter_(film)

https://fr.wikipedia.org/wiki/Computer_Augmented_Design_And_Manufacturing

https://en.wikipedia.org/wiki/Cray_X-MP

https://en.wikipedia.org/wiki/VAX-11